Innledning

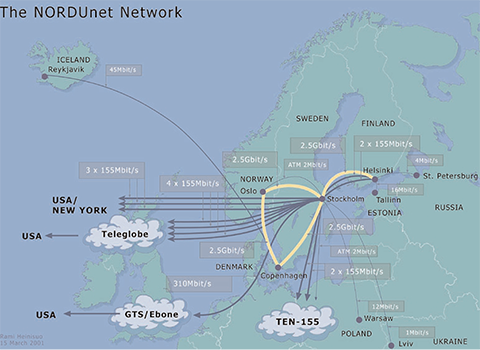

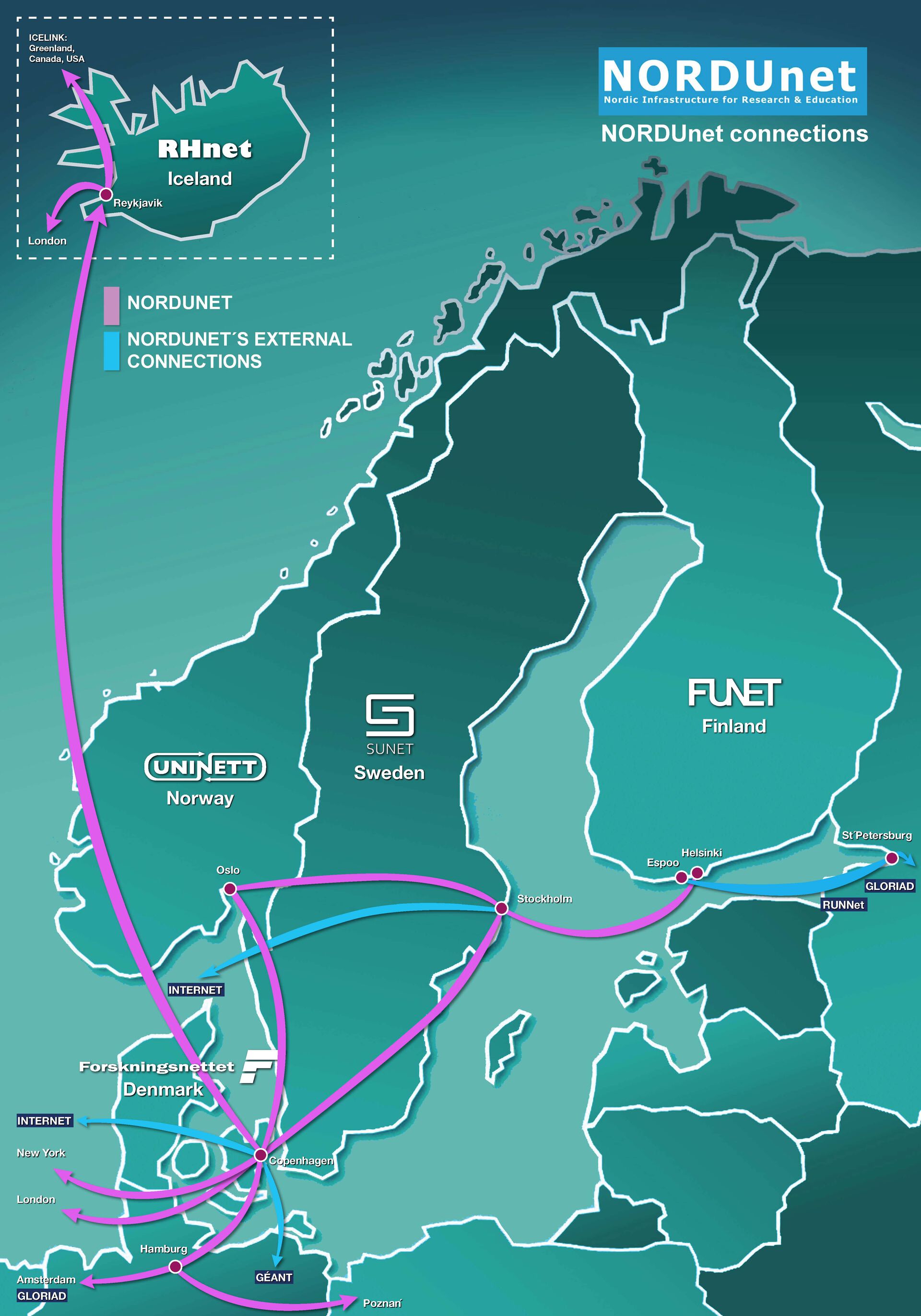

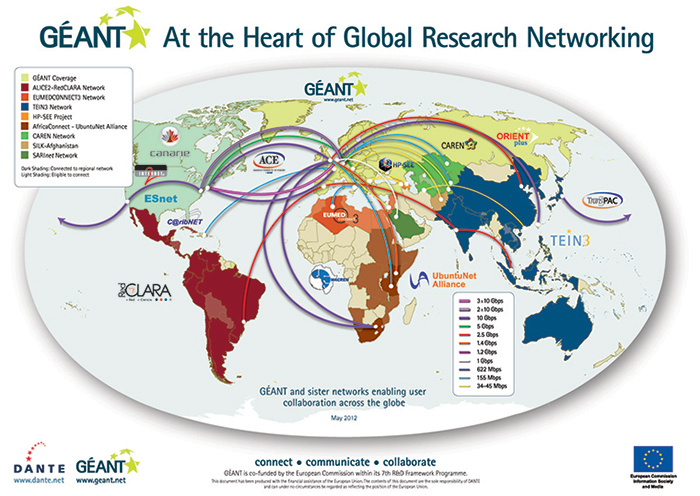

I 2009 ble en operasjon på St Olavs Hospital i Trondheim overført til en konferanse i Daejeon i Sør-Korea i sanntid og med en oppløsning som gjorde det mulig å se vevstrukturer som er usynlig for det blotte øye. Overføringen skjedde over en ‘optisk sti’ gjennom fibernettene til seks ulike forskningsnett som sammen med UNINETT (gjennom NORDUnet) deltar i et internasjonalt samarbeid om utvikling av fiberoptiske tjenester, – Global Lambda Integrated Facility (GLIF).

I dagens fibernett er 10 Gbps en vanlig overføringskapasitet. Teknologien som ble brukt i eksemplet foran, heter Wavelength Division Multiplexing (WDM) og deler opp bølgelengden til lyset i en optisk fiber i ‘optiske stier’ (kalt ‘lambda’-er) som hver har en overføringskapasitet på 10 Gbps. Tilgjengelig teknologi kan i skrivende stund (sommeren 2013) multiplekse opptil 160 slike, noe som gir en samlet kapasitet på 1600 Gbps (1,6 Tbps, terabit pr sekund, billioner bit pr sekund).

Dette gir kapasiteter i en størrelsesorden som er nær ubegripelig for de aller fleste av oss. Teknologien brukes da også til å overføre data fra eksperimentene med partikkelakselleratoren Large Hadron Collider (LHC) ved det europeiske forskningssenteret CERN. Der sysles det med like ubegripelige fenomener knyttet til universitets opprinnelse og naturens innerste hemmeligheter. Her genereres det data i slike mengder at lysstiens kapasitet må benyttes for å distribuere dem til de tusener av forskere, inkludert forskere ved våre universiteter, som skal prøve å finne en mening i dem. Sommeren 2012 førte dette til at vi fikk ‘se’ det såkalte Higgs-bosonet, noe som la en lenge etterlengtet brikke på plass i verdensbildet til kosmologer, partikkelfysikere, kvantemekanikere, astrofysikere og andre som prøver å finne svar på de grunnleggende spørsmålene om livet, universet og evigheten.

Rimelig eksotisk, men denne teknologien er nærmere oss enn vi aner. Samme teknologi brukes i varierende grad i fibernettene som nettoperatørene har bygd ut og bygger ut for milliarder av kroner for å ta unna trafikken vi genererer i vår daglige, langt mindre eksotiske bruk av Internett. Ifølge de siste oversiktene bor 86% av befolkningen mindre enn en kilometer fra nærmeste fiberknutepunkt, 65% kan enkelt få fiber hjem og en økende andel (nærmere 380.000 i 2012) av landets godt og vel 1,7 millioner bredbåndsabonnenter benytter seg av dette tilbudet. Riktignok får vi foreløpig ikke hver vår 10 Gbps lysende sti ut i verden. Inntil videre må de fleste av oss nøye seg med noen titalls Mbps hjem, men det gir allikevel kapasitet nok til at vi nokså uhindret kan fortsette både vår nyttige og vår tøysete bruk av Internett.

Det er akkurat dette de siste par tiårene for det meste har handlet om, – kapasitet. En sterkt økende kapasitet i nett og utstyr har tilrettelagt og fremmet den utviklingen av teknologi, tjenester, anvendelser og brukeropplevelser som vi i dag kjenner som allmennhetens og offentlig og privat sektors bruk av Internett. I løpet av disse tjue årene har Internett gått fra å være for noen få til å bli tilgjengelig for alle hvorsomhelst og nårsomhelst, og med smarttelefonenes inntog har vi Internett med oss i lomma eller håndveska hele tiden. Og vi har fått ‘Internett av ting’ der applikasjoner innhenter, utveksler, bearbeider, formidler og lagrer informasjon om ting basert på merking av tingene ved hjelp av RFID-brikker, QR-koder, strekkoder eller på andre måter.

I denne perioden gikk Forskningsnettet og Internett hver sin vei. Internett utviklet seg til det nett av tjenester for alle som vi kjenner i dag. Her tok andre aktører førersetet. Forskningsnettet forble en naturlig del av Internett og Internett fortsatte å være viktig for Forskningsnettet, samtidig som virksomheten ble mer rettet mot infrastruktur, tjenester og ressurser for forskning og (høyere) utdanning.

UNINETTs misjon i et nøtteskall

Eksemplet fra 2009 oppsummerer på mange måter UNINETTs ambisjon for Forskningsnettet i et nøtteskall, – Forskningsnettet skal være teknologisk i forkant, basert på internasjonalt samarbeid og ha nytteverdi i form av brukbare og anvendbare ressurser, tjenester og kapasiteter for hele landets forskning og utdanning. Langt fra alle trenger ressurser på nivå med lysende stier verden rundt, men alle trenger tilgang til gode fellesressurser og -tjenester med kapasitet og egenskaper tilpasset de ulike virksomhetenes formål, gjenstandsområde, metodikk, arbeids- og samarbeidsformer.

I dag er omtrent 180 institusjoner innen forskning og utdanning tilknyttet Forskningsnettet og alle er tilknyttet med Gbps-forbindelser. Det dekker hele landet, går langs hele kysten fra Kirkenes i nord til Halden i sør og strekker seg til både Longyearbyen og Ny-Ålesund. Tilknytningene i stamnettet har to veier fram, noe som gir en svært høy grad av feiltoleranse, tilgjengelighet og stabilitet.

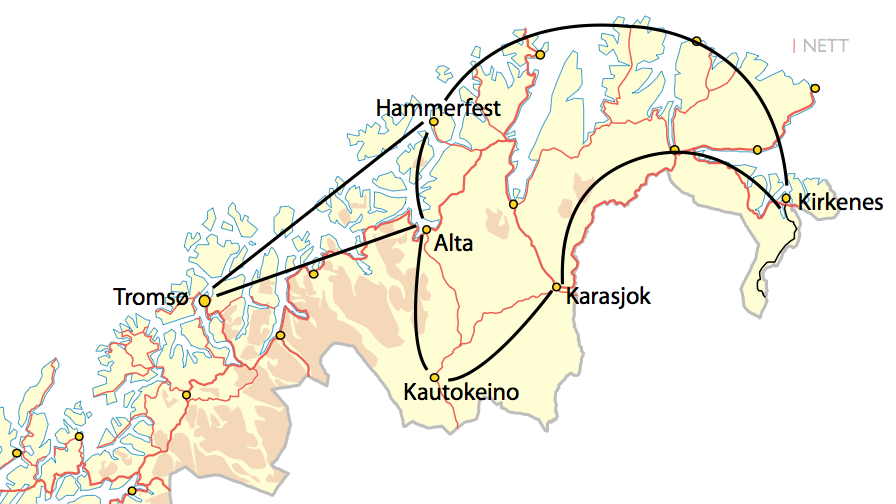

Figur 5-1: Finnmarksringen er det siste store utbyggingsprosjektene i UNINETT-regi. Tilsammen 210 km fiber knytter fylket sammen og til det regionale senteret i Tromsø.

Etableringen av UNINETT AS

Utbyggingen av Forskningsnettet var kjerneoppgaven det daværende Kultur- og vitenskapsdepartementet ga UNINETT da UNINETT ble etablert som departementseid aksjeselskap fra 1. januar 1993:

UNINETT A/S har som formål og oppgave å:

- Utvikle et landsdekkende elektronisk datanett for forskning og utdanning med tjenester på linje med det beste som finnes i det internasjonale akademiske miljø

- Påskynde bruk av åpne internasjonale standarder innen datakommunikasjon

- Sørge for samtrafikk med aktuelle nasjonale og internasjonale nettoperatører

- Stimulere til nødvendig forsknings- og utviklingsaktivitet innen UNINETTs virksomhetsområde

UNINETT medlemmer er norske universitet, høgskoler, forskningsinstitusjoner, videregående skoler, grunnskoler, offentlige bibliotek, museum og andre ikke-kommersielle institusjoner med tilknytning til forskning og utdanning.

I det nye selskapet ble Petter Kongshaug tilsatt som administrerende direktør og har hatt denne stillingen til i dag. Bjørn Henrichsen fotsatte som styreleder og hadde dette vervet fram til 2009. Da overtok assisterende universitetsdirektør ved Universitetet i Tromsø Britt Elin Stenveg dette vervet.

UNINETT var på det tidspunktet en beskjeden organisasjon med fem ansatte, et budsjett på fem millioner kroner og i overkant av 200 medlemmer. Stamnettet i Forskningsnettet ble året etter oppgradert til 512 Kbps (1/20.000-del av kapasiteten i dagens stamnett) og utenlandsforbindelsen til 2 Mbps (1/5000-del av dagens).

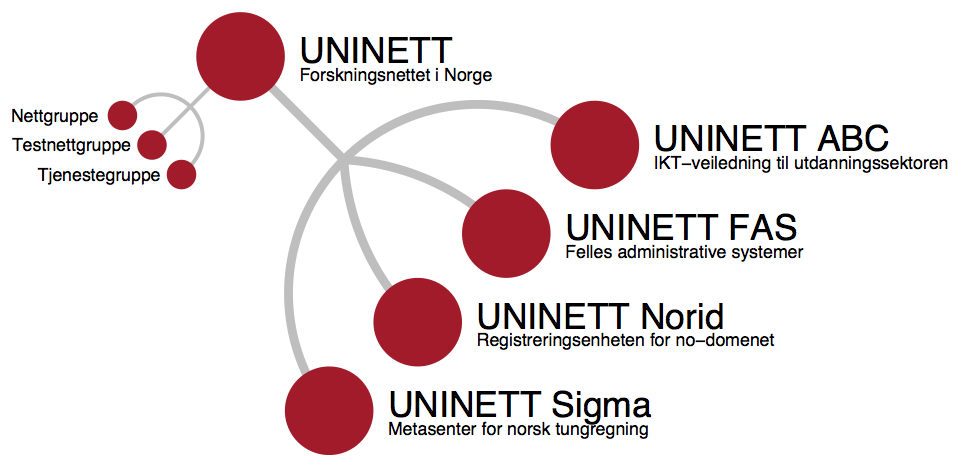

Det har med andre ord tuslet mange bit gjennom nettene siden den gang. UNINETT AS har i mellomtiden vokst til en stor organisasjon med nesten 100 ansatte og med over 200 millioner kroner i årsomsetning. Mesteparten av denne veksten kom i årene etter år 2000. I disse årene har organisasjonen fått utvidet ansvarsområde og har i dag ansvar for en rekke oppgaver og tjenester i tillegg til utbygging og drift av Forskningsnettet. Dette er tjenester, systemer og ressurser som er vel så viktig, om ikke viktigere for mange flere, enn muligheten til å overføre data på lysende stier halve jorda rundt. Dette bredde- eller fellesaspektet har også vært et varemerke for UNINETT hele tiden, å være til for og levere til hele fellesskapet i sektoren.

Etableringen av generelt Internett i Norge

Fram til UNINETT ble etablert som aksjeselskap i 1993, var UNINETT i praksis den norske delen av Internett. På det tidspunktet var det to medlemsgrupper i UNINETT. Primærmedlemmene var utdannings- og forskningsinstitusjoner og andre institusjoner som falt inn under departementets avgrensing av UH-sektoren. I perioden 1987-92 var det departementet som betalte disse institusjonenes tilknytning til UNINETT. I tillegg kom andre organisasjoner og foretak som benyttet ordningen med sekundærmedlemsskap til å skaffe seg tilknytning til Internett. Disse fikk de samme tjenestene som primærmedlemmene, men måtte betale en medlemsavgift som tilsvarte antatt kostpris for tilknytningen. Blant de omtrent tretti sekundærmedlemmene UNINETT hadde i 1992 var en rekke av de største norske bedriftene og organisasjonene. For de fleste av dem var dette deres første kontakt med Internett.

Utenfor UNINETT var det vesentlige endringer på gang. De første aksessleverandørene (eller ISP-ene, ‘Internet Service Provider’, leverandører av Internett-tjenester) ble etablert i 1991-2. Disse solgte tilgang til Internett til privat og offentlig sektor og allmennheten. I følge sterke indisier klagde en av de nyetablerte ISP-ene (TelePost) til departementet over at ordningen med sekundærmedlemsskap undergravde markedet for dem. Etter anmodning fra departementet startet UNINETT med å avvikle sekundærmedlemskapet. Da en forsiktig anmodning bare hjalp sånn passelig, vedtok UNINETTs styre å heve tjenesteavgiften til 200.000 kr i året. I brevet til sekundærmedlemmene 29. mars 1993 ble dette begrunnet med:

I takt med at det nå etableres kommersielle nettoperatører i markedet har UNINETTs styre nå funnet det hensiktsmessig å legge forholdene til rette for at UNINETT skal rendyrke sin profil som en akademisk nettoperatør og ikke gå til det skritt å bli en generell konkurrent på det åpne telekommunikasjonsmarkedet.

Sekundærmedlemmene fikk tilbud om å si opp medlemskapet med øyeblikkelig virkning. Før sommerferien var tilbakelagt det året, var sekundærmedlemmene borte og ordningen avviklet.

Med dette var løpet lagt. Internett var på vei ut til allmennheten og til privat og offentlig sektor, mens UNINETT fortsatte utbyggingen av Forskningsnettet, samtidig som organisasjonen ivaretok rollen som leverandør av Internett-tjenester til sektoren. Gjennom nesten hele 90-tallet var UNINETT den klart største tjenesteleverandøren og forskning og utdanning sto for mer enn halvparten av Internettrafikken.

Samtidig var vi i ferd med å bli en del av et større fellesskap. Til dette fellesskapet bidro UNINETT og sektoren med to kritiske funksjoner:

- I 1987 overtok UNINETT rollen som navneautoritet med ansvar for administrasjon av domenenavn i .no-domenet. I 1995 ble dette organisert som UNINETT Navneautoritet og fra 1996 som den selvfinansierende tjenesten Norid. Etter noen år som del av datterselskapet UNINETT Trofast AS, ble UNINETT Norid AS etablert som datterselskap i 2003 og forvalter fortsatt .no-domenet

- I 1993 etablerte USIT ved Universitetet i Oslo Norwegian Internet eXchange (NIX) som samtrafikkpunkt for norske Internett-tjenesteleverandører. UNINETT var sammen med Telepost og EUnet de første ISP-ene som brukte NIX. Etter den tid har USIT drevet NIX og i dag er nesten 60 tjenesteleverandører tilknyttet og det er etablert regionale IX-er i Tromsø, Trondheim, Bergen og Stavanger

Både Norid og NIX ivaretok og ivaretar fortsatt funksjoner av grunnleggende betydning for utviklingen av Internett. For å sikre likebehandling av aktørene både var og fortsatt er det ønskelig og nødvendig at disse funksjonene forvaltes og drives av en nøytral tredjepart. UNINETT og USIT sto klar da dette kom på dagsorden og har løst oppgavene til de flestes tilfredshet i årene etterpå.

NIX – Norwegian Internet Exchange

Det norske samtrafikkpunktet ble etablert ved USIT, Universitetet i Oslo i 1993 og formidlet samtrafikk mellom UNINETT, TelePost og EUnet. I de neste årene fulgte de andre nett- og tjenesteleverandørene (Oslonett, Schibstednett, PowerTech, etc) og større organisasjoner, institusjoner og foretak (Statens Datasentral, Posten, IBM, NRK med flere). I 2005 passerte antall NIX-kunder 50, i dag er tallet i overkant av 60.

De første kundene fikk en 10 Mbps-forbindelse til NIX-en. Fra omtrent 1998 var 100 Mbps det normale, mens Gbps-forbindelser ble tilgjengelig etter årtusenskiftet, – 1 Gbps i 2001 og 10 Gbps i 2005. I 2000 ble NIX2 etablert for å gi tilbud til operatører som ønsket redundans i samtrafikken. For tiden er det et 20-talls operatører som benytter seg av denne muligheten.

I 2000 var NIX-trafikken størst i arbeidstiden med en trafikktopp på 300-350 Mbps på en vanlig dag, mens helgetrafikken var lav. I 2012 er trafikkmønsteret snudd helt om, – den største trafikken nå er på kveldstid med trafikktopper opptil 45 Gbps på en vanlig dag og like stor trafikk i helga som på hverdager.

Tilbud om samtrafikk for IPv6 ble etablert i 2003. Omtrent to tredjedeler av NIX-kundene benytter seg av dette og har både IPv4- og IPv6-tilknytning til samtrafikkpunktet.

I alle årene fra 1993 og fram til i dag er det Kjetil Otter Olsen og hans medarbeidere i USITs nettgruppe som har stått for administrasjon, utbygging, vedlikehold og drift av NIX. I praksis har det ikke vært nedetid av betydning på samtrafikktjenesten i dette tidsrommet.

Tredje og fjerde generasjon av Forskningsnettet

En ny dagsorden var satt for UNINETT og øverst på denne sto videreutvikling av infrastruktur, tjenester og ressurser i Forskningsnettet.

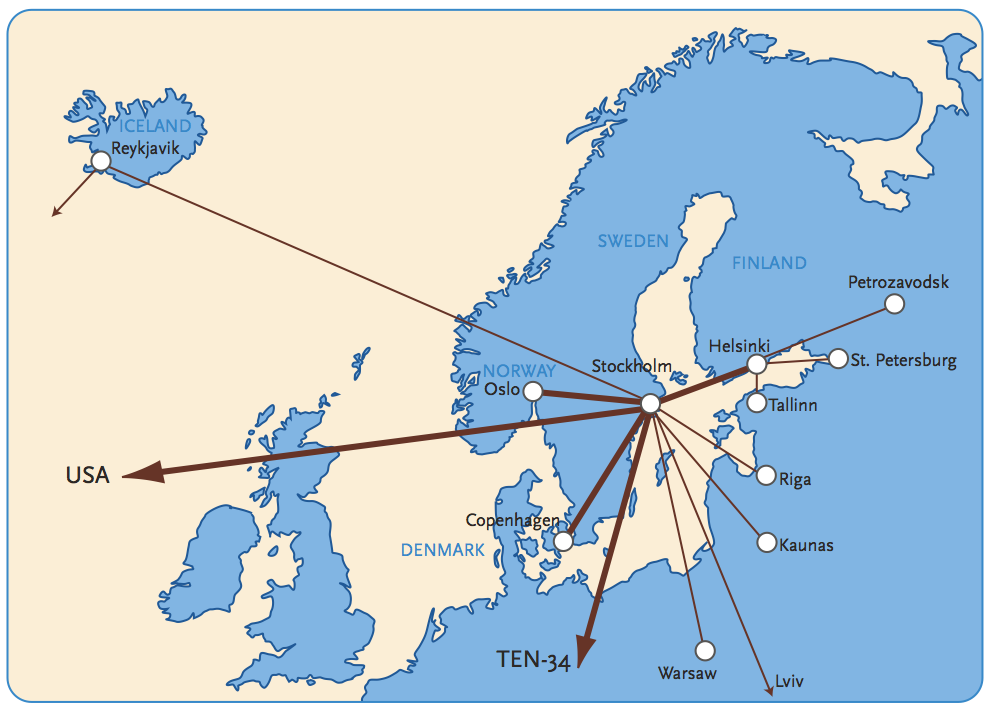

På begynnelsen av 1990-tallet var det åpenbart at andre generasjon av Forskningsnettet – multiprotokollnettet – nærmet seg slutten. I 1993 hadde Internett etablert absolutt hegemoni i UNINETT med 30.000 maskiner og over 100.000 brukere. For de tre andre ‘nettene’ var antallet maskiner og brukere langt lavere og på sterk tilbakegang. I 1994 ble UNINETT DECnet og UNINETT EARN avviklet. UNINETT OSInett forsvant året etter og de siste restene av X.25 forsvant i 1. januar 1998 (X.500-katalogen ble riktignok ikke erstattet av LDAP før 1. januar 2001). Dette falt sammen med avviklingen av det europeiske Forskningsnettet EuropaNet og åpningen av TEN-34 (‘Trans Europe Network at 34 Mbps’). Med dette forsvant de siste restene av OSI-nett også fra de europeiske forskningsnettene.

Fra midten av 90-tallet var Internettprotokollene eneste bæretjeneste for ressursene og tjenestene og tredje generasjon av Forskningsnettet i Norge var en realitet. I denne fasen var Forskningsnettet et ‘rent Internett’, det rutet kun IP-trafikk. Med denne generasjonen kom også overgangen til Mbps-kapasitet over leide telelinjer. Stamnettet fikk relativt raskt 10 Mbps-forbindelser og et stadig flere endeinstitusjoner fikk 2 Mbps-forbindelser. NORDUnet-forbindelsen var på 34 Mbps og NORDUnets forbindelser til USA og Europa på henholdsvis 34 og 22 Mbps.

Rundt årtusenskiftet startet så byggingen av fjerde generasjon av Forskningsnettet, etter hvert omtalt som ‘Giganett’, med Gbps-kapasiteter i en landsomfattende fiberinfrastruktur.

To parallelle fortellinger, ett vendepunkt

Fra 1993 fulgte Forskningsnettet og generelt Internett ulike utviklingsløp nasjonalt og internasjonalt. Koplingen mellom de to varierte, men for begge var årene før og etter år 2000 et vendepunkt på mange vis. Fram til år 2000 var en vesentlig del av arbeidet i både Forskningsnettet og generelt Internett rettet mot å bygge ut kapasiteten i infrastrukturen. Trafikken mer enn fordoblet seg årlig i denne perioden og spiste raskt opp oppgraderingene av båndbredde. På slutten av 90-årene skjedde det en vesentlig utbygging av fiberforbindelser nasjonalt og internasjonalt, og med dette kom Gbps-kapasitet i nettene. I kombinasjon med lavere årlig trafikkvekst etter år 2000 medførte dette at kapasiteten i infrastrukturen ikke lenger var en like krevende utfordring.

For generelt Internett var introduksjonen av bredbånd i kombinasjon med trådløse nettløsninger og høyhastighets mobilnett i årene etter årtusenskiftet avgjørende for utviklingen. Like viktig ble smarttelefonene som begynte å komme på markedet på det tidspunktet. Sammen endret de vår hverdag, vi fikk Internett med oss overalt alltid. Med børskrakket i mars 2000 ble ‘dot.com’-bonanzaen på slutten av 90-tallet avløst av en mer edruelig kommersiell virksomhet på Internett.

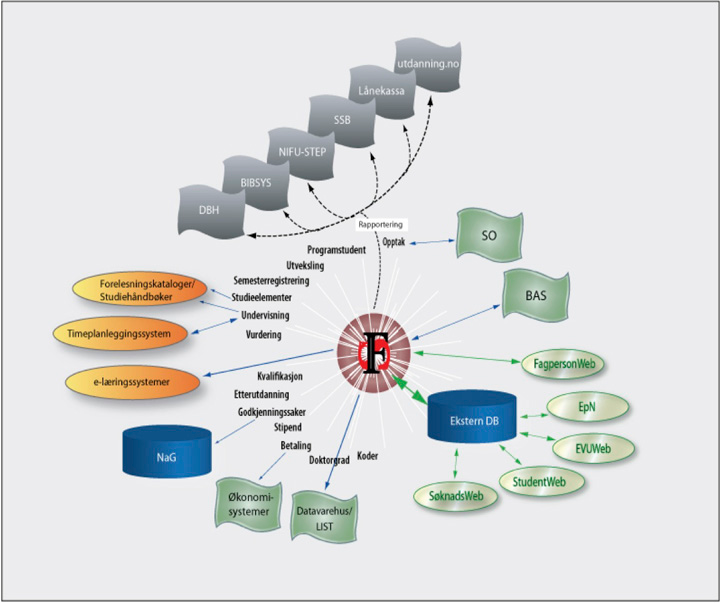

For Forskningsnettet markerte årtusenskiftet avslutningen på et tiår med sterkt engasjement i utbygging av infrastruktur og tjenester for høgskolene og starten på byggingen av en fiberoptisk infrastruktur som etter hvert ble til dagens landsomfattende Giganett. Samtidig startet forskningsnettene med å rette oppmerksomheten mot hva denne infrastrukturen skulle være bærer av. Sentralt i dette sto forskningens og utdanningens behov for tjenester og ressurser og hvordan brukerne enklest og mest effektivt kunne få tilgang til og bruke disse. Ut av dette kom mellomvareløsninger, ressurser for vitenskapelig databehandling, multimedieanvendelser, administrative fellestjenester med mer.

Introduksjonen av bredbånd var også et vendepunkt i den offentlige IT-politikken. Markedsdrevet bredbåndsutbygging ble nå den ene store IT-politiske saken, mens planer om bruk av IT til å effektivisere og forbedre (og rasjonalisere) offentlige tjenester avløste 90-tallets sektorplaner og lett vidløftige planer for ‘den informasjonsteknologiske infrastrukturen’ og ‘informasjonsmotorveien’.

Utviklingen av generelt Internett

Etableringen av Internett som et globalt, allment tilgjengelig tjenestenett skjedde raskt. I 1990 var omtrent 25 land koplet til NSFNET og antall noder hadde passert 100.000, i 1997 var de fleste land i verden tilknyttet og antall noder hadde passert 10 millioner. Etter dette ble tallene for store til at de ga særlig mening for de fleste av oss. Det var tre vesentlige forhold som muliggjorde og drev utviklingen framover:

- Åpningen av Internett for allmennheten og kommersiell virksomhet i tospann med offentlige myndigheters ambisjoner om å tilrettelegge for ‘den elektroniske motorveien’ og ‘den informasjonsteknologiske infrastrukturen’

- Den teknologiske utviklingen i tråd med Moores lov

- World-Wide Web som Internetts ultimate ‘killer application’

Åpningen av Internett og ‘den elektroniske motorveien’

Mot slutten av 1980-årene fikk interessen for Internett og TCP/IP utenfor universitetene og forskningsinstituttene konkrete uttrykk. UUNET (Unix to Unix Network) startet med å levere tilgang til e-post, News, programvarearkiv med mer over UUCP fra 1987 og bygde Alternet med TCP/IP som ryggrad i 1989. Samtidig ble “The World” (world.std.com) etablert som første ISP med leveranse av Internett-tjenester til privat sektor og allmennhet og ble fulgt av andre ISP-er. Disse tjenesteleverandørene hadde behov for samtrafikk slik at kunder og tjenester kunne kommunisere med hverandre. Ikke minst ville de ha tilgang til NSFNETs linjer, tjenester og brukere.

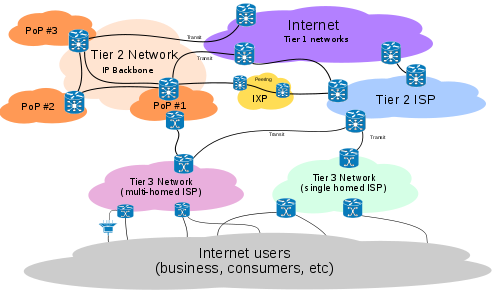

Samtrafikken ble løst ved hjelp av samtrafikkpunkter, Internet eXchange Providers (IX, IXP), som NIX er den norske utgaven av. Disse sørget for at trafikken gled friksjonsfritt mellom brukere og maskiner på tvers av de ulike tjenesteleverandørenes nett. UUNET etablerte Commercial Internet eXchange (CIX) som første IX-en i 1991 sammen med to andre ISP-er. Internett begynte å strukturere seg.

Figur 5-2: Internetts arkitektur på midten av 1990-tallet. Brukerne er knyttet til tjenesteleverandørenes nett som så er er knyttet sammen på forskjellig måte i et hierarki som samlet utgjør Internett.

Kopling til NSFNET kom i kjølvannet av offentlige myndigheters inntog. Det startet i USA med vedtakene av “High Performance Computing and Communications Act” i 1991 og “Scientific and Advanced Technology Act” i 1992. I løpet av kort tid ble vokabularet utvidet med begreper som ‘nasjonal informasjonsinfrastruktur’ og ‘informasjonsmotorvei’ og vi fikk en gjenoppliving av Marshall McLuhans ‘globale landsby’.

Visjonen var å samle offentlige og private nett i et nasjonalt nett som kunne transportere alle datatyper og elektroniske tjenester og gjøre dem tilgjengelig for offentlig og privat sektor og nasjonens borgere. Dette var en visjon som myndigheter i mange land, inkludert de nordiske, delte på midten av 90-tallet.

Datidens Internett, NSFNET, hadde brukere (som de telte i millioner), et landsomfattende linjenett og internasjonale forbindelser til en rekke land. NSFNET var samtidig offentlig finansiert og pålagt retningslinjer som eksplisitt forbød kommersiell virksomhet. Gjennom de nevnte politiske prosessene ble det etablert midlertidige ordninger som åpnet for tilknytning og samtrafikk med kommersielle aktører. Dette var en sterkt omdiskutert og kontroversiell ordning som overlevde til 1995. Da overlot NSFNET ansvaret for Internetts ryggrad til kommersielle nettoperatører. Dette la de siste brikkene på plass i arkitekturen for Internett slik vi kjenner den i dag.

I 1995 hadde alle de nordiske landene lagt planene for sine nasjonale informasjonsinfrastrukturer og informasjonsmotorveier. I Norge kom “Den IT-baserte infrastrukturen i Norge – Status og planer” i 1995 og “Den norske IT-veien – Bit for bit” i 1996. Gudmund Hernes oppsummerte dette slik i UNINyTT, UNINETTs nyhetsblad:

Vårt land er nå i ferd med å hektes på en informasjonsverden der kunnskap formidles via globale nett som blir den sentrale kilde til velferd og makt, til medbestemmelse, erkjennelse og opplevelse.

Kirke-, utdannings- og forskningsdepartementet med den samme Hernes i spissen ga samtidig ut en bred gjennomgang av visjonene og utfordringene i boka “Den digitale revolusjon”. Det var med andre ord på tide å gjøre noe.

Litteraturen vi leste

- Kurt Vonnegut: Player Piano (1952)

- William S Burroughs: Naked Lunch (1959)

- Philip K Dick: Do Androids Dream of Electric Sheep? (1968)

- Douglas Adams: The Hitchhiker's Guide to the Galaxy (1979), The Restaurant at the End of the Universe (1980), Life, the Universe and Everything (1982) og So Long, and Thanks for All the Fish (1984)

- Vernor Vinge: True Names (1981)

- William Gibson: Neuromancer (1984), Count Zero (1986) og Mona Lisa Overdrive (1988)

- Neal Stephenson: Snow Crash (1992), Diamond Age (1993)

Moores lov og den teknologiske utviklingen

Moores lov utfoldet seg samtidig i all sin prakt. I tillegg til eksponentielt økende kapasitet på alle typer datamaskiner, lagringsmedier og nettkomponenter, er årene etter 2000 mest av alt preget av en bemerkelsesverdig utvikling av brukerutstyret. Mens stasjonære og etterhvert bærbare maskiner var enerådende på 90-tallet, fikk disse selskap av en rekke ulike typer brukerutstyr etter år 2000. Vi fikk Internett på smarttelefoner, spillkonsoller, MP3-spillere, GPS-navigatører, TV-apparater, nettbrett og mye annen elektronikk.

Vi opplevde samtidig en rask og omfattende utvikling på infrastruktursiden. Ulike bredbåndsteknologier brakte Internett med akseptabel kapasitet hjem og utviklingen av trådløse nett og høyhastighets mobilnett i årene etterpå, gjorde Internett praktisk talt allestedsnærværende.

Smarttelefonene toger inn

Smarttelefonene og deres ektefødte barn, nettbrettene, står for den vesentligste utviklingen av brukerutstyr, brukeratferd og brukeropplevelse på Internett etter år 2000.

På 90-tallet hadde vi mobiltelefoner til å ringe med og til å sende tekstmeldinger. Vi hadde PDA-er (‘Personal Digital Assistent’) til å administrere kontakter, avtaler, gjøremål og andre ting som holdt orden på hverdagen. Vi fikk kameraer som tok digitale bilder og vi fikk MP3-spillere for å spille musikk. Vi hadde med andre ord en ‘dings’ for hvert formål.

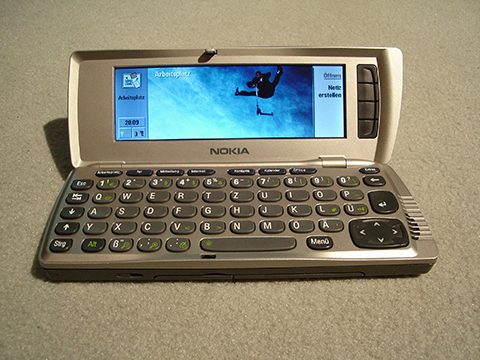

Det neste naturlige og logiske skrittet var å samle dette i ett og samme utstyr. Rundt 2000 lanserte datidens markedsledere på mobilmarkedet, Ericsson og Nokia, de første smarttelefonene. Dette var mobiltelefoner med PDA-funksjonalitet og de var utstyrt med tastatur og større skjerm. Av de mest suksessrike var Nokia Communicator som kom i en rekke utgaver utover på 2000-tallet.

Figur 5-3: Nokia Communicator 9210 lansert i november 2000 med Symbian som operativsystem.

I løpet av kort tid fikk disse telefonene fargeskjerm, skjermer med bedre oppløsning og trykkfølsomme skjermer. Så ble kamera, MP3-spiller og noe senere GPS bygd inn i dette utstyret. Og det tok av. I løpet av kort tid var salget av slike multifunksjonelle mobiltelefoner større enn samlet salg av standalone PDA-er, digitale kamera og MP3-spillere og ‘smarttelefon’ ble en del av vokabularet.

Samtidig fikk mobilnettet større kapasitet. Vi fikk EDGE, GPRS, HSDPA og 3G, og 4G står for døren. Dette åpnet for ny bruk og nye tjenester på mobiltelefonen. Med tilknytning til trådløst nett (WLAN) ble smarttelefonene fullverdige Internett-klienter med e-post, web og alt annet som hørte til.

I motsetning til de første mobiltelefonene og de andre dingsene var smarttelefonene datamaskiner med standardiserte operativsystem, programmeringsgrensenitt og brukeromgivelse. Symbian var det dominerende operativsystemet omtrent hele tiåret etter at de første smartelefonene ble introdusert. Det ble utviklet i et samarbeidsprosjekt mellom Psion som var en av PDA-pionérene og tre av de store på mobiltelefoner rundt årtusenskiftet, – Nokia, Erichsson og Motorola. Brukeromgivelsene ble også gjenstand for standardisering. På dette området ble det riktignok tre standarder, der Nokia satset på en (S60) og Ericsson, Motorola med flere en annen (UIQ), mens japanske Sony, Panasonic, Fujitsu, NEC med flere samlet seg om et tredje (MOAP). Sammen med Symbian utgjorde disse en utviklingsplattform for applikasjoner og smarttelefonene ble raskt utstyrt med alt fra kalender, kontakt- og gjøremålslister, tekstbehandler og regneark til spill og annen underholdning, – samt e-post, web og andre nettjenester.

Apple entrer arenaen, tett fulgt av Google

Apple lanserte iPod og iTunes i 2001 og erobret i løpet av kort tid markedet for bærbar musikk.

Etter et mislykket samarbeid med Motorola om en smarttelefon med iTunes, var selskapet klar for et nytt framstøt med lanseringen av iPhone med iOS som operativsystem i 2007. I løpet av kort tid erobret de også markedet for smarttelefoner. Samtidig hadde de løftet smarttelefonen opp på et nytt nivå når det gjaldt funksjonalitet og ikke minst når det gjaldt brukeropplevelse. Dette ble videreført i nettbrettet iPad i 2010. Over natta ble ‘App Store’ og ‘app-er’ et viktig innslag i dagligtalen.

Figur 5-4: Første iPhone lansert av Apple i 2007

Google kom like etter med Android, et Linux-basert operativsystem for smarttelefoner. Høsten 2007 ble HTC Dream lansert som første Android-telefon. I løpet av 2010 hadde Android passert alle andre og var størst på operativsystem for smarttelefoner, samtidig som den største produsenten Android-baserte smarttelefinre, Samsung, alene solgte flere smarttelefoner enn Apple.

Ubegrenset kapasitet, tilnærmet

Utviklingen av smarttelefonene er en god illustrasjon på Moores lov som sier at stadig økende datakraft pakkes i stadig mindre komponenter. Denne miniatyriseringen har gitt smarttelefonene en behandlingskapasitet tilsvarende det en velvoksen datamaskin hadde for bare få år siden.

I den andre enden av skalaen finner vi høykapasitets databehandling (HPC – High Performance Computing) for vitenskapelige og andre formål. Der brukes antall flyttallsoperasjoner pr sekund (Flops) som mål på regneanleggenes ytelse. Abel, regneanlegget som ble installert ved Universitetet i Oslo våren 2012 hadde en teoretisk ytelse på 258 Teraflops (billioner – 1012 – flyttallsoperasjoner i sekundet). Med en målt ytelse på 172 Tflops holdt det til en plass blant de 100 første (nummer 96 for å være nøyaktig) på det årets juniliste over de raskeste regneanleggene i verden (‘Top 500 Supercomputing Sites’). På novemberlisten havnet den som nummer 134 (til sammenligning hadde nummer 96 på denne listen 252 Tflops, nesten en halv gang større ytelse enn Abel). Neste gang listen publiseres vil Abel neppe ha en plass blant de 300 raskeste dersom anlegget ikke bygges ut i mellomtiden.

Det samme er tilfelle dersom målet er antall instruksjoner pr sekund. IBM System/370 var den desidert mest solgte datamaskinen på 70-tallet. Den prosesserte en million instruksjoner i sekundet (MIPS), noe som etter hvert ble brukt som et annet mål på ytelse. Abel benytter Intels nye prosessorgenerasjon Intel Core i7 (‘Sandy Bridge’). Hastigheten på disse er i størrelsesorden 100.000 MIPS, noen versjoner litt mindre, andre en del mer. Abel ble ved installasjonen utstyrt med godt over tusen slike.

Figur 5-5: Fra installasjonen av Abel, den nye regneressursen ved Universitetet i Oslo med en fornøyd IT-direktør i forgrunnen.

Resultatet er billigere datakraft, svært mye billigere. For 50 år siden var en ytelse på en Gflop (en milliard – 109 – flyttallsoperasjoner pr sekund) langt utenfor økonomisk rekkevidde. Den ville krevd kapasiteten til 17 millioner av datidens standardmaskin IBM 1620 og kostet et par-tre norske pensjonsfond (1,5 billioner dollar) i datidens pengeverdi. I 1984 kom Cray X-MP med en ytelse på en Gflop til en pris på 15 millioner dollar. På slutten av 90-tallet kom klynger bygd på standard maskinvare som senket prisen betydelig. I 1997 ga en slik installasjon denne ytelsen til 30.000 dollar og prisen falt videre til 1000 dollar i 2001 til 48 dollar i 2007 og mindre enn 2 dollar i 2011.

Tilsvarende eksponentiell utvikling har også vært regelen for andre deler av databehandlingen, – lagring, minne, skjermoppløsning, etc. Alt i alt en utvikling som i økende tempo har gitt oss billigere utstyr med økt ytelse og kapasitet og med ny funksjonalitet. Nå spiller ikke slike tall noen særlig rolle utover å fortelle om en rivende teknologisk utvikling. Kapasiteten er med andre ord på plass, om vi evner å sette de ulike bitene sammen og programmere den til gjøre nyttige ting for oss, avhenger av helt andre forhold.

Internett til alle tider alle steder

Sett med dagens øyne, var 90-tallet ei traurig tid for brukerne av Internett. Med unntak av dem som hadde god tilgang til Internett på jobben, var privatbrukere i hovedsak henvist til ulike typer oppringte forbindelser. Dette gjaldt også det store flertallet av små og mellomstore bedrifter. Dette var forbindelser med en kapasitet på noen titalls Kbps.

I tillegg til at dette var tregt, ustabilt og vanskelig å sette opp, kostet det penger, i begynnelsen mye penger. I første halvdel av 90-tallet kostet en times daglig Internett-bruk i størrelsesorden 25.000 kr i året (som utgjorde en høyst merkbar del av en gjennomsnittlig årsinntekt på den tiden). Og brukervennlig var det knapt. Etter 1995 brakte priskriger kostnadene ned på et langt rimeligere nivå, men det var fortsatt langt fra en kostnadsfri virksomhet. Televerkene ga oss riktignok ISDN, men det representerte ikke det store spranget. Det var litt mindre tregt, litt mindre ustabilt, men fortsatt dyrt, og fortsatt lite brukervennlig.

Allmenn tilgang til bredbånd over telefonlinjer og kabel-TV-nett etter år 2000 åpnet for et skred av brukere og tjenester. Det var først etter dette at Internett og Internett-bruken slik vi kjenner det i dag fikk sin utforming. Bredbånd var enklere å sette opp, raskere, stabilere og billigere, i alle fall sett på bakgrunn av erfaringene fra 90-tallet. Det gjorde det mulig å være ‘på nett’ hele tiden for noen få hunderlapper i måneden, – med alt det førte med seg. I løpet av de nærmeste årene kom trådløse nett hjemme og i offentlige rom og nye generasjoner mobilnett med kapasitet for dataoverføring. En vesentlig del av befolkningen i Norge har mulighet for å få optisk fiber hjem, noe som på litt sikt kan gi et ytterligere, vesentlig løft og medføre endringer i våre vaner for når vi er på nett og hva vi gjør der.

Den siste kilometeren hjem

På 90-tallet var kapasiteten på forbindelsen den siste kilometeren hjem den store hindringen for utbredelsen av Internett. Etter år 2000 har ulike bredbåndsteknologier langt på vei ryddet dette hinderet av veien. I stortingsmelding nr 49 (2002-2003) “Breiband for kunnskap og vekst” ble bredbånd definert slik:

Bredbånd er toveis kommunikasjonsnett som kan overføre ulike former for data som tekst, lyd, og levende bilder og som må kunne bære nye tjenester og tillate at mange bruker nettet samtidig.

Ser vi bort fra mobilt bredbånd som nå er på full fart inn, omfattet utbyggingen av bredbånd tre teknologier. Bredbånd over kabel-TV-nettet var for så vidt først ute. I 2000 hadde over tre fjerdedeler av landets første 20.000 bredbåndsabonnenter denne tilknytningen. I løpet av et par år var bredbånd over telefonnettet dominerende og har vært det fram til i dag. Fra omtrent 2005 begynte optisk fiber hjem å gjøre seg gjeldende.

Da antallet bredbåndsabonnenter passerte en halv million i 2004 og en million i 2006 dominerte bredbånd over telefonnettet med en markedsandel på mellom 80 og 90%. Etter det har optisk fiber hjem hatt den største veksten og i 2012 hadde nesten 380.000 av landets vel 1,7 millioner abonnenter denne tilknytningen. Bredbånd over kabel-TV-nettet har vokst jevnt og sikkert hele tiåret og hadde i 2012 over en halv million abonnenter, mens andelen bredbånd over telefonnettet har falt betydelig de siste 4-5 årene og utgjorde 740.000 i 2012.

Mobilt bredbånd er på vei inn. Både Telenor og Netcom har landsdekkende tredje generasjons mobilnett (såkalt 3G) med en båndbredde fra noen hundre Kbps til et par Mbps. I 2012 hadde nesten 1,4 millioner abonnenter slik tilknytning. Begge de nevnte mobiloperatørene er i gang med å bygge ut fjerde generasjons mobilnett (4G) med vesentlig større båndbredde.

En vesentlig trekk (defekt vil mange si) er det asymmetriske ved de aller fleste bredbåndsløsningene. Overføringskapasiteten er fem-ti ganger større nedstrøms til brukeren enn den er oppstrøms fra brukeren. Størst forskjell er det på bredbånd over kabel-TV-nettet, mens den er minst for optiske løsninger.

Minimumskravet til bredbånd har endret seg drastisk i denne perioden. Da bredbånd ble introdusert, var 640/128 Kbps regnet for å være godt nok for de fleste anvendelser. De siste årene har 8/1 Mbps vært standarden, mens 50/10 Mbps omtales i ulike sammenhenger som å være en standard om kun kort tid. I 2012 har nesten halvparten av bredbåndsabonentene mer enn 10Mbps nedstrøms og 12% har mer enn 30 Mbps.

Web entrer scenen

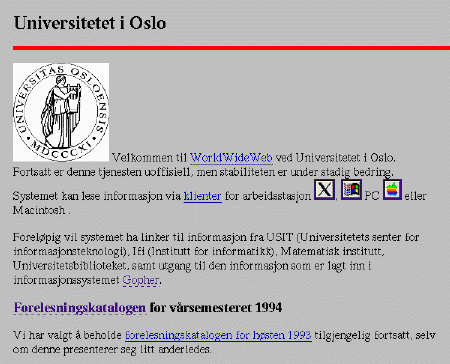

World-Wide Web ble den virkelige ‘killer application’ for generelt Internett etter av NCSA (National Center for Supercomputing Applications) i 1993 lanserte Mosaic som den første grafisk orienterte Web-leseren og nettsiden “What's New?” med oversikt over web-steder og web-tjenester.

Figur 5-6: Denne Web-siden ved Universitetet i Oslo senhøsten 1993 er et typisk eksempel på urutgaven av web med lett strukturert tekst, enkle illustrasjoner og lenker til andre nettsider.

Teknologien Web bygde på ble utviklet av Tim Berners-Lee og hans medarbeidere ved det europeiske forskningssenteret i CERN på slutten av 80-tallet. I 1993 erklærte CERN at denne teknologien skulle være allment og fritt tilgjengelig uten restriksjoner. Da var det 200 kjente web-tjenere som sto for 1% av Internett-trafikken. Året etter var antallet kjente web-tjenere mangedoblet og Web hadde overtatt plassen som tjenesten med størst trafikk i Internett, – to år etter at de første web-sidene ble publisert. I 2000 passerte antallet nåbare web-sider en milliard. I 2011 ble det anslått at de store søketjenestene (Google, Yahoo, Bing) hadde indeksert 7,5 milliarder web-sider, mens antallet nåbare web-tjenere var passert 350 millioner. Og disse tallene vokser.

Etter kort tid var det åpenbart at NCSAs “What’s New?”-side ikke var tilstrekkelig til å holde seg oppdatert på det som skjedde av interessante ting på nettet. Vi fikk emnekataloger med “Jerry’s Guide to the World-Wide Web” som ble til Yahoo! og vi fikk roboter (såkalte ‘crawlere’) som trålet nettet og indekserte hver web-side de kom over i databaser som søketjenester som Alta Vista, Lycos og andre brukte til å svare på våre søk etter nye opplevelser.

I kjølvannet av Mosaic kom Netscape i 1994 med Mosaic-utvikler Marc Andreessen i spissen. Med Netscape Navigator var de omtrent alene på arenaen for nettlesere, – på midten av 90-tallet brukte 9 av 10 web-surfere denne nettleseren. Først etter at Microsoft innså hvor gigantisk feilgrep det var å lansere MSN (Microsoft Network) som en konkurrent til Internett i 1995, ble Netscape Navigators posisjon utfordret av Internet Explorer. Det startet den store ‘browser-krigen’ som på slutten av 90-tallet satte sitt stempel på nettsidene med advarsler om at “Denne siden vises best i Internet Explorer” og “Denne siden vises best i Netscape”. I denne krigen var våpenet nye elementer og funksjoner på nettsidene og begge parter sørget for at det kun var egen browser som støttet dem. Netscape introduserte JavaScript, mens Microsoft kom med Active X, begge deler for å utvikle dynamiske elementer på nettsidene.

Nettleserkrigen utspant seg på mange fronter og resulterte i Internet Explorers totale dominans de første årene etter 2000, mens Netscapes nettleser forsvant. Utover på 2000-tallet kom nye aktører (Mozilla Firefox, Google Chrome og Apple’s Safari, samtidig som Opera holdt stand) og reduserte Internet Explorer til å bli den største av noen få store.

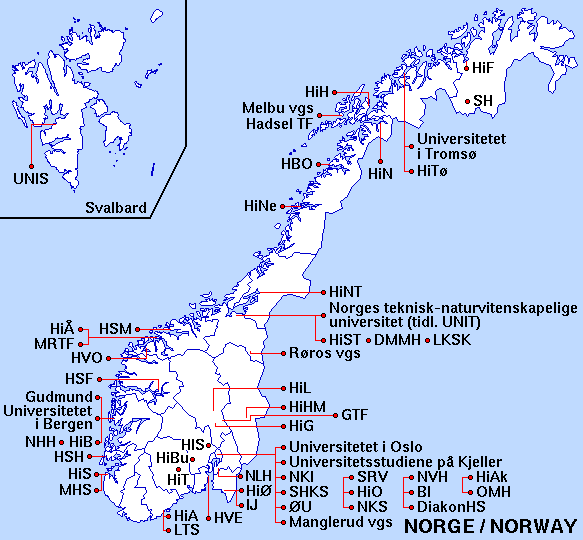

Universitetet i Oslo var, sammen med Universitetet i Tromsø blant de aller første som tok Web i bruk i Norge. Et UNINETT-prosjekt utført ved Universitetet i Tromsø utviklet Web-kartet, – et Norgeskart der kjente Web-tjenere var lagt inn med klikkbare lenker. I desember 1993 lå det lenker til omtrent 50 nettsteder i dette kartet.

Figur 5-7: I 1993 lagde Universitetet i Tromsø et klikkbart kart over det norske Web-landskapet. UNINETT tok over arbeidet med dette i 1995. Da var antallet Web-tjenester allerede så stort, så kartet måtte begrenses til forsknings- og utdanningsinstitusjonenes nettsteder. Dette ble autogenerert og etter hvert delt opp i regionale kart, noe UNINETT har fortsatt med fram til i dag.

Emnekatalogene og søkemotorene var de første tjenestene. Så kom e-handelsstedene med Amazon i spissen (1994), markedsplassene med Craigs List (1995), nettauksjonene med eBay (1995) og betalingstjenestene med PayPal (1998), samt webmail-tjenester som Hotmail (1996) og emnekatalogene Best of the Web (1994) og Open Directory Project (1998), for å nevne noen av de nettstedene som har fulgt oss siden den tid. Fra omkring år 2000 fulgte P2P-fildeling (‘peer-to-peer’), Web 2.0, semantisk web og sosiale nettverk. I rask rekkefølge kom tjenestene og omgivelsene som har lagt beslag på manges arbeids- og fritid fram til i dag:

- 1998: Google, MSN.com

- 1999: Napster, Messenger, Netflix

- 2000: Blogger.com, Gnutella, Freenet

- 2001: Wikipedia, BitTorrent, iTunes, KaZaa

- 2002: Friendster, Last.fm

- 2003: MySpace, LinkedIn, Skype, Second Life, del.icio.us, MediaWiki

- 2004: Facebook, Flickr, World of Warcraft, Podcast, Blogster

- 2005: YouTube, Windows Live, Google Earth

- 2006: Twitter, WikiLeaks, Khan Academy, AboutUs, SlideShare

- 2007: Kindle, Gmail, App Store

- 2008: Spotify, Zoho

- 2009: Google Docs, Bing, WIMP

- 2010: Instagram

- 2011: Google+

De som fortsatt er operative, brukes av millioner, for noens vedkommende hundrevis av millioner brukere daglig, og de rekrutterer daglig stadig nye brukere. Og da er det ikke tatt med nettsteder og tjenester beregnet på brukere tilhørende andre språksamfunn enn vårt, for eksempel det kinesiske.

Bøkene som ga oss innsikt og kunnskap

Vi leste bøker, mange bøker og leseropplevelsen av noen av dem henger ennå igjen:

- Marshal McLuhan: Understanding Media (1964), The Medium is the Massage (1967)

- Tracy Kidder: The Soul of a New Machine (1981)

- Stephen Levy: Hackers. Heroes of the Computer Revolution (1984)

- Douglas Comer: Internetworking with TCP/IP: Principles, Protocols, and Architecture (1988)

- Evi Nemeth et al: UNIX System Administration Handbook (1988)

- Don Libes, Sandy Ressler: Life with Unix: A Guide for Everyone (1989)

- Andrew Tannenbaum: Computer Networks, 2nd Edition (1989)

- John Quarterman: The Matrix; Computer Networks and Conferencing Systems (1990)

- Samuel J Leffler, Marshall Kirk McKusick: The Design and Implementation of the 4.3 BSD Unix Operating System (1991)

- Carl Malamud: Exploring the Internet (1992)

- Ed Krol: The Whole Internet Users Guide and Catalog (1992)

- Peter Salus: A Quarter Century of Unix (1994)

- Nicolas Negroponte: Being Digital (1995)

- Peter Salus: Casting the Net (1995)

- Manuel Castells: The Information Age: Economy, Society, Culture (1996-98):

- Vol 1: The Rise of the Network Society

- Vol 2: The Power of Identity

- Vol 3: End of the Millenium

- Katie Hafner: Where Wizards Stay Up Late: The Origins Of The Internet (1998)

- Tim Berners-Lee: Weaving the Web: The Original Design and Ultimate Destiny of the World-Wide Web by its Inventor (1999)

- Lawrence Lessig: Code and other Laws of Cyberspace (1999)

- Glyn Moody: Rebel Code: Linux and the Open Source Revolution (2000)

- Janet Abbate: Inventing the Internet (2000)

Generelt Internett i Norge på 90-tallet

Utviklingen av generelt Internett i Norge kan også deles i to perioder med år 2000 som vendepunkt.

Internett i Norge på 90-tallet startet som sagt i det svært små og eksploderte i siste halvdel av ti-året da ‘alle’ skulle ha en e-postadresse og en web-adresse på visittkortet. Ifølge Statistisk sentralbyrå hadde mer enn 50% av husholdningene Internett hjem i 2001, mens 75% av virksomheter med flere enn ti ansatte hadde tilkopling til Internett.

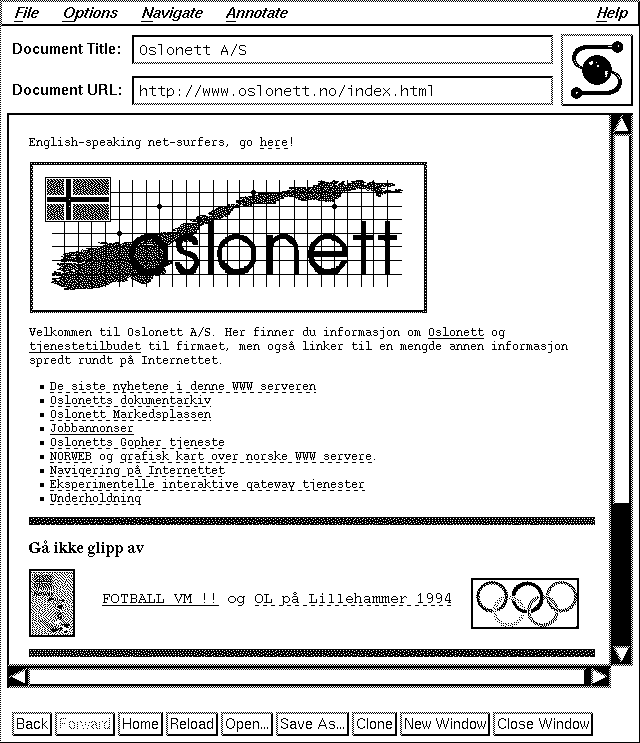

Det var to grupper som hver på sin front drev utviklingen framover. Den gruppa som kom først på banen var aksessleverandørene (ISP-ene), – foretakene som solgte tilknytning til Internett til privatpersoner og til foretak i privat og offentlig sektor. Fra tidlig 90-tall etablerte disse seg med en eller flere tjenermaskiner og hyller med modemer. I dette var Oslonett pioneren og Televerket, senere Telenor den dominerende.

Den andre gruppa var innholds- og tjenesteleverandørene som utviklet og vedlikeholdt nettsteder, portaler, e-handelssteder og andre tjenester i nettet. Aksessleverandørene var også på dette markedet, også her var Oslonett en pioner. I tillegg ble en rekke nye foretak etablert med Internett og Web som sentralt innslag i forretningsplanen.

Sentralt blant de nye foretakene var de såkalte ‘web-byråene’. Noen av dem hadde sin opprinnelse i etablerte bransjer som reklame, aviser og andre medier, men de fleste ble startet mer eller mindre fra bar bakke, gjerne med kjøkkenbenken som utgangspunkt. En del av dem vokste raskt og ble representanter for det de fleste muligens husker best fra denne perioden, – det som i ettertid omtales som ‘dot.com’-bobla eller ‘Internet-bobla’ og som Robert Frostad og Magnus Thomassen portretterte ganske presist i boka de ga ut i 2001: “Dot-konk – Historien om det kommersielle Internett i Norge”.

Oslonett

I utviklingen av generelt Internett i Norge på 90-tallet utførte Oslonett og dets etterfølgere vesentlige deler av arbeidet. De var først i landet med å selge tilgang til Internett til privatbrukere og til foretak i privat og offentlig sektor. De var også først med å tilrettelegge mange av tjenestene og ressursene som ble utviklet. Og de var de som tidligst, tydeligst og mest konsekvent bygde sin virksomhet på teknologien og arbeidsformene i Internett.

Oslonett ble etablert på det som senere er omtalt som ‘pizzamøtet’ 12. desember 1991 av en gruppe på 16 personer med bakgrunn i IT-miljøene i Informatikkbygget i Gaustadbekkdalen i Oslo, – Institutt for informatikk, USIT og Norsk Regnesentral. Etter møtet kom det to til, slik at gruppa talte 18 deltakere. I invitasjonen til pizzamøtet skisserte initiativtakeren Kjell Øystein Arisland denne forretningsideen for Oslonett:

Oslonetts forretningsidé:

Det er et behov i næringslivet, skolevesenet og offentlig forvaltning, blandt små og mellomstore bedrifter og institusjoner for:

- Rimelige postkassetjenester for elektronisk mail

- Tjenester for spredning av informasjon via oppslagstavler og mindre databaser

- Tilgang på public-domain programvare

- Tilgang på lokale newsgrupper moderert av eksperter på DOS, UNIX, nettverk etc., med jevnlig oppdaterte F.A.Q.-lister

- Rimelig tilgang på høyt kvalifiserte konsulenter på kort varsel uten å binde seg til langvarige engasjementer

Behovene for privatpersoner med PC er tilsvarende, med større vekt på private og personlige interesser. Så som hobbies og mer underholdningsbaserte behov.

Med betydelig Internett-kompetanse og ditto erfaring fra de nevnte miljøene etablerte Oslonett seg med en maskin og noen titalls modemer i lokalene til firmaet til en av initiativtakerne. Elektronisk post og USENET Networks News fikk de i første omgang fra NUUG, den norske UNIX-brukergruppa. Prosessindustriens landsforening (PIL) var på plass som den første kunden i 1992. Tilgang til tjenestene fikk de første brukerne via et egenutviklet program med navnet OnTerm (som ganske sikkert står for ‘Oslonett Terminal’). OnTerm var et rent tekstbasert grensesnitt og minnet mye om tjenestene på 80-tallets oppslagstavler.

Oslonett etablerte seg tidlig i frontlinja for Web og Web-tjenester i landet. De var blant de første som satte i drift web-tjenere med www.oslonett.no sommeren 1993. “Oslonett Markedsplassen” ble utviklet som en av de aller første norske Web-tjenestene (om ikke den første). Her kunne foretak, bedrifter, institusjoner og organisasjoner etablere en tilstedeværelse på nettet gjennom presentasjon av virksomheten, produktinformasjon, annonser etc. For ett av disse nettstedene, nettstedet for turoperatøren Arctic Adventures, ble Oslonett i 1994 nominert til prisen for beste kommersielle nettsted i Global Network Navigators ‘Best of the Web’-kåring. Det var mye prestisje knyttet til denne kåringa og nominasjonen ga Oslonett mye positiv omtale.

For Oslonett var 1994 et merkeår. I rask rekkefølge fulgte publisering i sanntid av resultatene fra OL på Lillehammer og fra folkeavstemningen om EU, tilretteleggingen av ComputerWorld Norge som nettavis, konferansenettsted for NettverksExpo 1995 med mer. Med disse tjenestene var Oslonett foran de aller fleste når det gjaldt løsninger for automatisert produksjon og publisering av innhold (noe som blant annet gjorde at ‘Kjetil André Aamodt’ ble til ‘Kjetil Second Aamodt’ i den automatiserte oversettelsen av OL-artiklene til engelsk).

Figur 5-8: Oslonett på Web anno 1993-4 vist i Mosaic.

Ikke nok med dette, i beste sendetid lærte de det norske folk Internett i NRK-programserien ‘Rondo’ våren 1995. I sin Web-avdeling bygde de opp en betydelig virksomhet med kursing i Internett, Web, HTML og tilgrensende emner i samarbeid med firmaet Intervett. Samme år kom Kvasir som ble den mest populære emnekatalogen over norske web-sider, inspirert av Yahoos emnekatalog og ‘What’s Cool?’. Emnekatalogen ble raskt utstyrt med søkefunksjonalitet og er fortsatt blant de største norske søketjenestene.

Et betydelige stykke ferdig arbeid i løpet av svært kort tid.

Kundemassen vokste raskt disse årene og det ble tidlig klart at Oslonett trengte flere ressurser. Ved etableringen av selskapet bidro hver av deltakerne med 5.000 kr til aksjekapitalen, samtidig som de forpliktet seg til å arbeide gratis for selskapet en måned i året. Et abonnement kostet 500 kr i måneden. Dette ga ikke de økonomiske musklene som skulle til for å møte blant annet behovet for investeringer i økt linjekapasitet. I tillegg trengte de internasjonal forbindelse, noe som virkelig kostet på den tida. De trengte med andre ord en partner som hadde adskillig dypere lommer enn dem selv.

Denne partneren fant de etter hvert i TelePost Communications som Stortinget hadde vedtatt opprettet i 1991. Stortingets intensjon var å etablere TelePost som ‘hele Norges elektroniske postkontor’ og var et av de siste uttrykkene for ambisjonene om datakommunikasjon som en offentlig teletjeneste. Televerket og Postverket eide hver sin halvpart av selskapet. Selskapet var operativ med TelemaX.400 som elektronisk posttjeneste fra 1992. Dette var den eneste kommersielle OSI-tjenesten som ble realisert i Norge. TelemaX.400 hadde noen hundre foretak i privat og offentlig sektor som kunder og var mjølkekua som sørget for at TelePost, i motsetning til de fleste andre, kunne levere regnskap med overskudd alle år.

I 1993 inngikk Oslonett og TelePost Communications en konsulentavtale som berget Oslonett over en viktig kneik. Avtalen innebar at de to delte markedet mellom seg, Oslonett skulle ha markedet for privatpersoner, mens TelePost tok bedriftsmarkedet. Avtalen sikret Oslonett tilgang til linjekapasitet, inkludert bruk av TelePost sin internasjonale forbindelse og tilknytningen til samtrafikkpunktet NIX og Oslonett kunne inntil videre vokse i aksessmarkedet for privatkunder, et marked der de allerede var størst.

Exit Oslonett og TelePost

På midten av 90-tallet begynte forholdet mellom Oslonett og TelePost å skrante. Avtalen om deling av aksessmarkedet og betingelsene knyttet til dette, hemmet Oslonetts virksomhet. Det endte med at Oslonett sa opp avtalen og flyttet utenlandsforbindelsen sin til det svenske teleselskapet Telia som på den tiden hadde etablert virksomhet i Norge. Med dette var delingen av markedet opphevet og Oslonett begynte igjen å selge aksess til private og offentlige foretak.

Postverket var samtidig på vei ut av TelePost og Televerket ble eneeier. Televerket var i mellomtida gjort om fra statlig forvaltningsbedrift til statsaksjeselskap og hadde endret navnet til Telenor. I avviklingen av TelePost var Postverket mest opptatt av å få ‘post’ ut av navnet og det endte med at foretaket ble videreført som en del av Telenor under navnet Telenor Online.

Oslonett trengte fortsatt en partner med dype lommer og fant den et helt annet sted enn mange spådde. Mediebedriftene var i ferd med å komme på banen og Schibsted var av dem som la mest krefter i dette. Etter en kort forhandlingsrunde kjøpte de Oslonett og sammen etablerte de Schibsted Nett. Med Oslonetts i underkant av 10.000 kunder var de størst og dobbelt så stor som Telenor Online.

Hverken Telenor Online eller Schibsted Nett hadde Internett som glassklar strategi på dette tidspunkt. Begge ønsket i utgangspunktet å etablere en norsk variant av America Online (AOL) som var noe av det heteste på den tiden. AOL var en stor oppringt oppslagstavle med en rekke brukertjenester og med en stor brukermasse og ikke en del av Internett. På det tidspunktet mente da også Bill Gates at Internett var en døgnflue og lanserte Microsoft Network (MSN) som konkurrent og alternativ til både AOL og Internett. Hverken Telenor Online eller Schibsted Nett gikk i samme fella som Bill Gates og Microsoft. De skiftet strategi og i løpet av kort tid etablerte de hver sin Internett-portal og var klar til å erobre nye kunder:

- Telenor Online: Scandinavia Online med Origo Index som emnekatalog og søketjeneste

- Schibsted Nett: SN Horisont med Kvasir som emnekatalog og søketjeneste

Priskrig og kampen om markedsandeler

Høsten 1995 var det klart for første runde i kampen om markedsandelene. Underveis hadde to aktører meldt seg på. EUnet var allerede i 1993 etablert som en konkurrent til TelePost og var størst i bedriftsmarkedet. PowerTech Information Systems etablerte seg som tjenesteleverandør i privatmarkedet og konkurrent til Oslonett i 1994. Omtrent samtidig kom Riksnett på banen som aksessleverandør finansiert av A-pressen.

Priskrigen startet høsten 1995 med at Telenor Online senket månedsprisen fra 740 kr til 199 kr for ubegrenset bruk. Schibsted Nett og de andre fulgte etter. EUnet introduserte modem for 1 kr sammen med Internettabonnement. Da røyken la seg fram mot sommeren 1996 hadde Telenor Online vokst til 65.000 privatkunder og var størst, men med de mest misfornøyde kundene. De hadde ikke infrastrukturen på plass som kunne håndtere tusenvis av nye kunder i uka og opptattsignal fra modemet ble et like utskjelt som velkjent fenomen.

Priskrigen tæret på de finansielle musklene til Schibsted Nett som med sine vel 50.000 privatkunder var nest størst. Det samme gjaldt de andre aksessleverandørene som hadde langt færre kunder. Det var på tide med konsolidering og den kom på slutten av året da Telenor Online og Schibsted Nett inngikk en samarbeidsavtale:

- Telenor Online overtok Schibsted Netts aksesskunder og ble dominerende blant aksessleverandørene med 75% av privatkundene og i underkant av 40% av bedriftskundene (der EUnet fortsatt holdt stand)

- Scandinavia Online ble videreutviklet som Internett-portal i et felleseid selskap som ble etablert i 1997 under navnet SOL AS

I 1996 etablerte de svenske teleselskapene Telia og Tele2 seg som aksessleverandører, samtidig som noen av de mindre trakk seg tilbake. I 1997 var det dags for en ny priskrig som endte med at Telenor Onlines markedsandel sank til 60%, mens Tele2 etablerte seg som nest størst med omtrent en femtedel av markedet. I tillegg til disse kom Telia og EUnet og sammen hadde de det aller meste av privatkundene resten av tiåret.

Med dette roet aksessmarkedet seg noen år inntil tida rundt år 2000 da kraftselskaper, kabel-TV-selskaper og en rekke andre kom på banen sammen med teleselskapene som bredbåndsleverandører.

Dot.konk

I ettertid framstår siste halvdel av 90-tallet som noe nær galskapens år. Det var en periode der gründere av alle slag rådde grunnen sammen med investorer i alle klasser. Sammen førte de an i en aksellrerende runddans som fikk en bråstopp med børsfallet våren 2000 og som etterlot noen svært mye rikere og langt flere med vesentlig slankere lommebok og ditto bankkonto. I disse årene var det ikke lett å se bak støyen og oppdage det som ble skapt av varig verdi. ‘Dot.konk’ var det vi husket og det var med ganske lett hjerte mange av oss sa farvel til 1990-årene.

Dot.com-bobla

Bobla startet i USA på midten av 90-tallet med børsnoteringen som prissatte Netscape til tre milliarder dollar i 1995. Yahoo! fulgte etter i 1996 og børsen prissatte firmaet til 34 milliarder dollar. Og de ble fulgt av nye børsnoteringer, aksjeemisjoner og oppkjøp til eventyrlige priser.

Fenomenet ble omtalt som ‘pre-/postfix investing’. Tilsynelatende var det nok å sette en ‘e’ foran foretaksnavnet og/eller ‘.com’ etter, så strømmet investorene til og aksjekursen føk til himmels. Lave renter bidro til et gunstig klima der entreprenører og investorer kunne utfolde seg. Troen på framtidig vekst fikk amatører og profesjonelle investorer til å ignorere bunnlinja og satse både egne og andres penger.

I en økonomi der ‘bli stor fort’ og høyest mulig markedsandel var det viktigste kriteriet på suksess, kunne ikke vare. I mars 2000 bråstoppet det. NASDAQ-indeksen for teknologiaksjer hadde doblet seg på ett år og passerte 5000 før nedturen begynte. En måned senere hadde den falt nesten en tredjedel og nedturen fortsatte de neste par årene og var nede på 1200 før den begynte å ta seg opp igjen.

I tillegg til massive nedbemanninger, kom det i kjølvannet av nedturen noen spektakulære konkurser. Og det ramlet til dels meget store lik ut av skapene. Triksing med selskapsinformasjon, regnskaper og aksjekurser viste seg å ha utløst et nivå av kreativitet som var minst like høyt, om ikke høyere, enn kreativiteten i produkt- og tjenesteutviklingen. Ikke akkurat av de stolteste øyeblikkene i menneskehetens historie.

Pengene fløt i ganske strie strømmer, formuer ble skapt (og tapt) over natta og foretak vokste og forsvant i raskt tempo. Tilsynelatende var det nok å presentere en luftig virksomhetsidé med de rette ordene og en forretningsplan med vage produktbeskrivelser og planer om ekspansjon, gjerne internasjonalt. Ispedd en dæsj halvkjendisdrevet medieomtale var dette nok til at investorer av alle slag sto klar til å kaste penger etter deg.

Dette var ‘den nye økonomien’. Etter hvert ble det åpenbart at det ‘nye’ med denne økonomien var at den ikke stilte krav om at foretakene skulle tjene penger, i alle fall ikke i år og heller ikke neste år. Tilsynelatende var det ingen som stilte spørsmål ved bunnlinja til disse foretakene. Tvert imot kunne det se ut som om det å tape penger var et av de viktigste kriteriene for å lykkes i denne nye økonomien:

Selv om mange selskaper med nettet som forretningsidé fortsatt taper penger, er børsverdien i mange tilfeller astronomisk. Årsaken er ofte at informerte investorer tror på den (i.e. ‘Den nye økonomien’). Og framdeles er det de amerikanske investorene og aktørene som forstår de nye spillereglene best. (sitert i Frostad og Thomassen: “Dot-konk – Historien om det kommersielle Internett i Norge”)

Denne uttalelsen i 1999 fra en av de toneangivende aktørene i denne perioden, Bente Sollid, oppsummerer det meste. Det var aksjeverdien som var drivkraften, ikke bunnlinja. Året etter hadde imidlertid de ‘informerte investorene’ mistet troen og selskapenes børsverdi falt ‘astronomisk’, mens de som ble kjøpt ut (med kontanter i stedet for aksjeposter) av sine selskaper i tide, kunne trekke seg tilbake med en hyggelig saldo på kontoutskriften. De som satt igjen i selskapene hadde noen helt andre utfordringer.

Realiteten var at kun et fåtall av selskapene som ble etablert i denne perioden, kunne vise fram et årsregnskap med overskudd. Svært ofte var det nok å gange årsomsetningen med ti for å få tallet for årets underskudd. Eksemplene er flere på selskaper som i løpet av få år hadde akkumulert underskudd i ti- og hundremillionersklassen.

I denne stemningen av eufori, ble selskapsetableringer, emisjoner og (ikke minst) oppkjøp gjennomført til aksjekurser som priset selskapene til ti- og hundretalls millioner. Internett-portalen SOL (Scandinavia Online) og rekrutteringsselskapet Stepstone gikk på børs tidlig i 2000 og ble notert til aksjekurser som prissatte dem til henholdsvis seks og elleve milliarder kroner, – mer enn datidens største industrikonsern Kværner og Elkem. Dette kunne ikke vare. Til sammen var IT-selskapene på Oslo Børs priset til over 100 milliarder kroner før nedturen startet. Da støvet etter børsfallet våren 2000 hadde lagt seg, hadde de fleste selskapene mistet 80-99% av aksjeverdien, dersom de ikke hadde gått konkurs underveis. Et år etter børsnoteringen var for eksempel SOL prissatt til en tidel av verdien året før, 600 millioner kroner. Et tiår senere eksisterer kun en liten håndfull av de selskapene som var børsnotert da bobla sprakk i 2001 og ingen av dem er i nærheten av å ha samme aksjeverdi i dag som de hadde den gangen.

En av de få av betydning som klarte å holde seg i skinnet og som hadde fokus på riktig sted i denne perioden, var Opera Software. I perioden fra etableringen i 1995 og fram til emisjonen våren 2000 sa grunnleggerne Geir Ivarsøy og Jon Stephenson Tetzchner nei takk til alle som ønsket å kjøpe seg inn, tilbud som ville gitt dem gevinster på flere titalls millioner (i kontanter). Først i mars 2000 fant de det riktige tidspunktet for å gå på børs og de gjorde det til en kurs som verdsatte selskapet til 500 millioner kroner. Året etter gjennomførte de en ny emisjon som prissatte selskapet til 1,2 milliarder kroner. Mens de fleste opplevde en rasering av aksjeverdien, doblet altså Opera sin verdi.

Det vi fikk med oss inn i det nye årtusenet

Ingen savner i dag Global Money Games, CoShopper, Bid2Day, Opticom, Boxman, New Media Science, Digital Hverdag, Birdstep, Online Club, yaTack, GiBud, Mogul Media, Active ISP og de andre boblene. I ettertid er det lett å glemme at noen av dem kom seg noenlunde ned på beina etter nedturen i 2000 og er i dag virksomme selskaper på en betydelig mer solid plattform. Med ‘dot.konk’ som bakteppe er det også lett å glemme at det ble gjort mye arbeid av varig verdi i disse årene. Det ble utviklet gode tjenester og tekniske løsninger, samtidig som vesentlig kompetanse og kunnskap ble bygd opp. Ut av disse årene kom en rekke tjenester og ressurser som i tiåret etterpå ble videreutviklet til det vi kjenner av tjenester i Internett i dag:

- Nettaviser og medietjenester:

- Kommunal Rapport første blad på nett i 1993, fulgt av ComputerWorld Norge som første nettavis i 1994

- Brønnøysunds Avis først på nett av dagsavisene i 1995, tett fulgt av Dagbladet, VG og Aftenposten

- digi.no og Nettavisen første rene nettaviser i 1996, ITavisen fulgte i 1997

- NRK Interaktiv i 1995

- Nettbank og tilliggende tjenester:

- BNBank med mottak og behandling av lånesøknader på nett fra 1995

- Sparebanken Hedmark første nettbank i 1996, tett fulgt av Landsbanken og Kredittkassen, de andre fulgte etter i 1997, mens DnB Nor var den siste av de store med nettbank i 1999

- Gjensidige først med forsikringstjenester på nett i 1996

- Christiania Fonds første nettsted for aksjehandel i 1997

- eHandelssteder, markeds- og annonseplasser av ymse salg:

- Oslonett Markedsplassen i 1993

- PowerSys med CD-butikk for Lars Kilevold i 1994

- Datavarehuset med ehandel fra 1994

- Akers Mic med CD-butikk på nett i 1995

- Peppes Pizza i 1995

- Bruns Libris bokhandel i Trondheim første norske nettbokhandel i 1995

- Eiendomsnett i 1996

- Finn.no i 1996

- Plussreiser første reisebyrå på nett i 1998, tett fulgt av SOLs Reisefeber og etter hvert den norske avdelingen av Expedia

- Jobshop etablert som et av de første nettstedene for jobbformidling, ble til rekrutteringsselskapet StepStone fra 1999

- Informasjons- og søketjenester, portaler:

- Oslonett med Kvasir emnekatalog i 1994 og med søketjeneste fra 1995

- Scandinavia Online og SN Horisont i 1995, slått sammen til SOL i 1997 og utvidet virksomheten til Sverige og Danmark i 1998

- Telenor Media med Gule Sider i 1995 og Origo Index i 1995

- Opoint med tjeneste for overvåking av nyheter på nett i 1996

- Internett-selskaper:

- Opera Software er allerede nevnt

- I tillegg, – Fast Search & Transfer med søketjenesten AllTheWeb.com. Fast ble etablert i 1997 og børsnotert i 2001. AllTheWeb.com ble solgt ut i 2003 og havnet etter hvert i Yahoo!, mens Microsoft kjøpte søkemotoren i 2008 for 6,6 milliarder kroner

Etter år 2000

Etter 2000 er varianter av disse tjenestene utviklet videre og i utstrakt bruk, samtidig som de har fått ny funksjonalitet og nye tjenester er introdusert. Bredbåndet brakte Internett hjem til oss, mens trådløse soner og mobilnett gjorde at Internett forfølger oss over alt. Ved siden av dette er det ehandelstjenester av alle mulige slag, samt sosiale medier og nettverk i alle avskygninger det som mest av alt har preget Internett etter år 2000. Mens Web på 90-tallet først og fremst var en formidler av informasjon, er web etter år 2000 i stor grad blitt en formidler av transaksjoner og personlige relasjoner. Hvilke sosiale, politiske, økonomiske og kulturelle endringer dette har fremmet og vært en drivkraft for, er det neppe noen som har overskuet eller har et klart bilde av.

Denne delen av fortellingen må imidlertid stoppe her. Det sier egentlig alt at vi leverer selvangivelsen og dusinvis av andre skjema, planlegger ferien, handler alt fra bøker til hus og gjør julehandelen, lever ut våre fobier og konspirasjoner, oppretter nye personlige relasjoner og reetablerer gamle og et utall andre ting ‘på nett’ som om det var det naturligste i verden.

Artiklene vi lærte av

Noen artikler og nettpublikasjoner var viktigere enn andre:

- Vannevar Bush: As We May Think (1945)

- Joseph Licklieder: Man-Computer Symbiosis (1960) og The Computer as a Communication Device (1968)

- Douglas Engelbart: Augmenting Human Intellect: A Conceptual Framework (1962)

- John Quarterman: Notable Computer Networks (1986)

- Tim Berners-Lee, Robert Cailliau: World-Wide Web – A Proporsal for a Hyper Text Network (1990)

- Brendan P Kehoe: Zen and the Art of the Internet (1992)

- Electronic Frontier Foundation: Big Dummy’s Guide to the Internet (1994)

- Tim Berners-Lee med flere: Semantic Web (Temanummer av Scientific American, 2001)

- Eric Raymond: The Cathedral & the Bazaar: Musings on Linux and Open Source by an Accidental Revolutionary (2001)

Offentlig sektor og politiske myndigheter

“Nasjonal handlingsplan for informasjonsteknologi 1987-90” var første offentlige næringspolitiske plan for informasjonsteknologi. Planen kom midt i en periode preget av vesentlige omlegginger av nærings- og industripolitikken og var en av de siste offentlige planene der industrireising og -utvikling var et sentralt virkemiddel. 1990-tallet representerte den endelige avslutningen av etterkrigstidas tunge offentlige engasjement i såvel næringsutvikling som utbygging av infrastruktur. I stedet var det ‘liberalisering’ med ‘deregulering’ og ‘fristilling’ av sektorer med tung offentlig regulering og virksomhet som styrte både næringspolitikken og andre politikkområder.

Handlingsplanen ble skrevet i en periode der utvikling av en norsk dataindustri var høyt prioritert og der Norsk Data fortsatt var ledestjerne og en viktig premissetter for offentlig politikk på området. Planen omfattet tiltak innenfor en ramme på fem milliarder kroner hvorav en milliard var ‘friske’ penger, – en vesentlig satsing selv med dagens målestokk. Planen ble oppsummert som vellykket når det gjaldt å øke kapasiteten på høyere utdanning innen informatikk og tilgrensende fagområder og når det gjaldt økte bevilgninger til forskning. Det viktigste var imidlertid at sysselsettingseffekten av planen var mislykket. I løpet av planperioden grunnstøtte norsk dataindustris flaggskip Norsk Data og etter Norsk Data kom ingen. I kjølvannet av handlingsplanen kom katastrofeprosjektene i offentlig sektor med blant annet WINIX-satsingen i skoleverket og Rikstrygdeverkets TRESS90-prosjekt.

I kombinasjon med endringene i næringspolitikken kom disse erfaringene kom til å prege den offentlige IT-politikken på 90-tallet og bidro til et langt lavere ambisjonsnivå enn tilfellet var på 70- og 80-tallet. I første halvdel av 90-tallet var sektorplaner med moderate mål for bruk av IT innen helsesektoren, utdanningssektoren og andre sektorer det sentrale i den offentlige politikken.

Først med den forannevnte “informasjonsmotorveien” som flaggsak på midten av 90-tallet kom de ambisiøse målene på nytt på dagsorden, – primært som festtale og lite i form av målrettete tiltak og offentlig satsing. I siste halvdel av 90-årene ble det produsert et betydelig antall utredninger og planer. Den røde tråden gjennom alt dette var bruk av IT for å utvikle både offentlig og privat sektor. Helt på slutten av tiåret ble fokus rettet mot å tilrettelegge for borgernes egen IT-bruk gjennom slagord som ‘den digitale allemannsretten’.

Ett av de områdene der det ble produsert resultater, var tilgang til offentlig informasjon på nett med Elektronisk søkbare offentlige publikasjoner (ESOP) i 1992 og Offentlig dokumentasjon og informasjon i Norge (ODIN) i regi av Statens informasjonstjeneste, først som prøveprosjekt i 1995 og deretter som permanent tjeneste i 1998, samt Stortingets informasjonstjeneste fra 1996 og KIMEN i 1998 (for den som måtte huske den). ODIN ble videreført som regjeringa.no i 2007.

Markedsdrevet utvikling av informasjonssamfunnet

Grunnlaget for IT-politikken som ble utviklet på 90-tallet og som har vært enerådende etter 2000 var tilrettelegging for en markedsdrevet utvikling av informasjonssamfunnet. Et av de mest pregnante uttrykkene for denne politikken kom i 1994 i form av EU-kommisjonens “Europe and the Global Information Society”, også kalt ‘Bangemann-rapporten’, lagt fram av Martin Bangemann, EU-kommisjonær for industri, informasjons- og telekommunikasjonsteknologi:

This Report urges the European Union to put its faith in market mechanisms as the motive power to carry us into the Information Age. This means that actions must be taken at the European level and by Member States to strike down entrenched positions which put Europe at a competitive disadvantage:

- It means fostering an entrepreneurial mentality to enable the emergence of new dynamic sectors of the economy

- It means developing a common regulatory approach to bring forth a competitive, Europe-wide, market for information services

- It does NOT mean more public money, financial assistance, subsidies, dirigisme, or protectionism

In addition to its specific recommendations, the Group proposes an Action Plan of concrete initiatives based on a partnership between the private and public sectors to carry Europe forward into the information society.

Bruk av markedsmekanismer avløste 1970- og -80-tallets store nasjonale og felleseuropeiske prosjekter for utvikling av høyteknologiske sektorer i Europa. En forløper for Bangemann-rapporten var EU-direktivet “ONP – Open Network Provisioning” fra 1990 som fastla strategien for å liberalisere telemarkedene gjennom å fristille og privatisere televerkene og konkurranseutsette teletjenestene. Dette direktivet satte dagsorden for den nasjonale politikken i de fleste land i Europa. og på slutten av tiåret var det europeiske telemarkedet snudd opp ned.

Markedsdrevet utvikling av infrastruktur og tjenester til tross, det var forsiktighet og tilbaketrekking som er hovedinntrykket av offentlige myndigheters IKT-politikk dette tiåret. Riktignok var det ambisjoner så det holdt i retorikken rundt informasjonsmotorveien, den norske IT-veien og den digitale allemannsretten og festtalene satt løst, ikke uventet løsest i Torbjørn Jaglands korte statsministerperiode i 1996-97. De praktiske resultatene viste imidlertid at Winix, TRESS90 og andre offentlige IT-prosjekter med langt fra vellykket utfall, hadde satte sine tydelige spor i det offentliges ambisjoner og handlinger.

Privatiseringen av Televerket

Telemonopolet var i økende grad et stridstema utover 1970- og 80-tallet. I 1987 ble rollen som tilsynsorgan skilt ut fra Televerket som Statens teleforvaltning, omdøpt til Post- og teletilsynet i 1997. Resten av Televerket ble delt i to, – basisorganisasjonen fortsatte under navnet Televerket med ansvar for infrastruktur, mens TBK – Televerkets bedriftsintern kommunikasjon ble etablert som konkurranseorganisasjon.

I 1989 kom utredningen “En bedre organisert stat“ som la grunnlaget for omfattende endringer i organiseringen av statlig virksomhet. I hovedsak gikk endringene ut på økte fullmakter til forvaltningsorganene og en utvikling i retning av selvstendige statseide selskaper innenfor en rekke sektorer, inkludert nasjonale infrastrukturer som teletjenester, jernbane og elektrisitetsforsyning.

For Televerkets vedkommende startet det med fristilling fra regjeringens styringsrett i 1992, fortsatte med omgjøringen fra forvaltningsselskap til statsaksjeselskapet Telenor AS i 1995 og avsluttet med privatiseringen av selskapet ved børsnoteringen i 1998. De svenske teleselskapene Telia og Tele2 etablerte seg i mellomtida som konkurrenter til Telenor. Da var allerede NetCom etablert som privat teleoperatør i markedet for mobiltelefoni.

For øvrig var innføringen av en felles teletakst for hele landet i 1997 noe av det siste Telenor gjorde før foretaket ble privatisert. Med dette kostet det like mye å ringe bekjente på den andre kanten av landet som til naboen i gata. På sett og vis representerte dette sluttføringen av Televerkets oppdrag med å gi hele befolkningen samme tilgang til teletjenester.

Privatiseringen av Telenor var omstridt da den skjedde og er det framdeles. Spesielt det forhold at Telenor fikk beholde aksessnettet (‘koppernettet’) fram til husveggen. I praksis innebar dette også at Telenor beholdt monopol på en vesentlig del av telenettet og således ble satt i en gunstig konkurranseposisjon i bredbåndsmarkedet. Maksimalt utbytte av dette ble da naturlig nok en viktig del av Telenors strategi. Dette ga også foretaket en sterk innflytelse på telepolitikken og senere bredbåndspolitikken. Denne posisjonen ble neppe svekket av at departementsråd i Finansdepartementet og leder av utredningen “En bedre organisert stat“, Tormod Hermansen ble administrerende direktør i Televerket i 1992 og hadde denne posisjonen i ti år fram til 2002.

Telenors monopol

Et viktig argument for å privatisere Televerket, var å avvikle Televerkets monopol og legge til rette for konkurranse i telesektoren. Resultatet ble en ny monopolist, Telenor. I følge Post- og teletilsynets rapport om markedet for elektroniske kommunikasjonstjenester var Telenors markedsandeler i 2012:

- Fasttelefon: 80%

- Mobiltelefon: 50%

- Mobildata: 57%

- Bredbånd:

- Over telefonnettet: 50%

- Over kabel-TV-nettet: 50%

- Over fibernett: 8%

- TV-signaler: 47%

- Annen elektronisk kommunikasjon: 59%

Offentlig IT-politikk etter år 2000

I 1999 tok daværende kommunal- og regionalminister Odd Roger Enoksen sine kollegaer samferdselsminister Dag Jostein Fjærevoll og nærings- og handelsminister Lars Sponheuim på senga da han lanserte ‘den digitale allemannsretten’:

Alle husstander og all offentlig og privat virksomhet skal ha tilgang til høyhastighetsnett til lik pris og i samme utbyggingstakt over hele landet.

Bondevik-regjeringen Enoksen var medlem av, ble avløst av Jens Stoltenbergs første regjering i 2000, og den nye næringsministeren Grethe Knutsen la fram denne regjeringens Handlingsplan for bredbåndskommunikasjon høsten 2000. Her ble den digitale allemannsretten lagt på is, samtidig som politikken abdiserte når det gjaldt å bygge ut infrastruktur:

Regjeringen ønsker en raskere og bredere geografisk utbygging av bredbåndsnett i regi av markedsaktørene. Konkurransen i markedet må styrkes. I tillegg bør det legges til rette for offentlig etterspørsel av bredbåndstjenester. Regjeringen ser det verken som riktig eller nødvendig at det offentlige selv bygger ut eller eier infrastrukturen. Unntak vil kunne gjelde av hensyn til forsvar og rikets sikkerhet.

Bredbåndspolitikken skal baseres på to typer tiltak:

- Styrking av konkurransen i markedet

- Styrking av offentlig etterspørsel etter bredbåndsnett og bredbåndstjenester

I tillegg vil en vurdere om det er behov for særskilte offentlige tiltak for områder eller grupper der det ikke er kommersielt grunnlag for utbygging. Regjeringens mål er at styrking av konkurransen og offentlig etterspørsel skal bidra til:

- Gode markedstilbud om tilknytning til bredbåndsnett til alle grunn- og videregående skoler, folkebibliotek, sykehus og kommuneadministrasjoner innen utløpet av 2002

- Gode markedstilbud om tilknytning til bredbåndsnett for alle norske husstander innen utløpet av 2004

Markedsaktørene skal således stå for utbygging og utvikling innenfor et forutsigbart og konkurranseorientert marked. Det offentlige skal ikke være en aktør som står bak grunninvesteringer i infrastrukturen. Det offentlige er derimot en tidlig og aktiv etterspørrer av produkter og tjenester. De særskilte tiltakene kommer eventuelt inn der tilbyderne i markedet ikke kommer opp med gode nok tilbud.

Regjeringen gikk inn med 350 millioner kroner i stimuleringstiltak, samtidig som første versjon av eNorge-planene ble lansert. Til sammenligning satte den svenske regjeringen i gang et fireårig utbyggingsprosjekt med en ramme på over åtte milliarder kroner.

eNorge-planene

Vesentlige deler av den offentlige IT-politikken etter år 2000 er knyttet til eNorge-planene. Med et halvt års mellomrom la Jens Stoltenbergs første regjering fram versjon 1.0, 2.0 og 3.0 av disse planene. Det overordnete målet var å effektivisere og forbedre offentlig sektor og forvaltningens kontakt med borgere og næringsliv:

- Elektroniske tjenester skal være hovedregelen for offentlige tjenester til brukerne

- Elektronisk saksbehandling skal være normen og akseptert på linje med papirbasert

- Elektronisk handel skal være førstevalg ved offentlige anskaffelser

Planene var operativt orientert ved at de hver inneholdt noen titalls konkrete tiltak innenfor en rekke departementers ansvarsområder. Framdrift i arbeidet med tiltakene ble rapportert månedlig.

Kjell Bondeviks andre regjering fulgte opp med to nye planer, – “eNorge 2005” i 2002 og “eNorge 2009 – Det digitale spranget” i 2005. Disse var mer prinsipielt og overordnet innrettet enn den første runden med eNorge-planer.

I kjølvannet ble begrepsapparatet utvidet med ‘digital kompetanse’, ‘døgnåpen forvaltning’, ‘digitalt førstevalg’, ‘digital allmenning’ med flere. I 2000 kom portalen norge.no med organisert og samlet tilgang til offentlig informasjon. I 2003 kom Altinn som portal for innlevering av skjema til offentlige myndigheter og fra 2005 var det mulig å levere selvangivelse i elektronisk form i denne tjenesten. Andre tiltak var markedsplassen ehandel.no for offentlige anskaffelser, innbyggerportalen Min side og sikkerhetsportalen eID.

Siste skudd på denne stammen er den rød-grønne regjeringens “På nett med innbyggerne – Digital agenda Norge” lansert våren 2013, lansert våren 2013 i kjølvannet av Stortingsmelding 23 (2012-13) “Digital agenda Norge – IKT for vekst og verdiskaping”.

I “St. meld. 49 (2002-3) Breiband for kunnskap og vekst” ble prinsippene videreført av Kjell Magne Bondeviks andre regjering: “Marknadsaktørane skal stå for utbygginga av infrastrukturen for elektronisk kommunikasjon og val av teknologi”. Det blir riktignok tatt noen forbehold om at dette ikke automatisk vil sikre likt tilbud over hele landet og at det derfor kunne bli nødvendig med tiltak for mer aktiv tilrettelegging for konkurranse og offentlig etterspørsel.

Høykom ble etablert i 1999 som en tilskuddsordning der målet var å bidra til at offentlige virksomheter over hele landet etterspurte høyhastighets informasjons- og kommunikasjonsteknologi. Høykom ble organisert som et program under Norges forskningsråd (NFR) og var et viktig virkemiddel i den offentlige IT-politikken. I forbindelse med stortingsmeldingen “Breiband for kunnskap og vekst” ble Høykoms mål formulert i to punkter:

- Bidra til fornyingen av offentlig sektor gjennom å stimulere til utvikling og bruk av bredbåndsbaserte tjenester for offentlig forvaltning og tjenesteyting

- Stimulere en markedsbasert bredbåndsutbygging gjennom etterspørsel etter bredbånd og bredbåndsbaserte tjenester

Programmet ble avviklet i 2007 og hadde da bidratt med rundt 700 millioner kroner i tilskudd til prosjekter i kommuner og fylker. Medregnet egenandel ble det tilsammen brukt mer enn 1,5 milliard kroner i de nesten ti årene programmet gikk (men fortsatt var dette et godt stykke bak svenskene).

Den digitale allemannsretten forsvant fra radarskjermen noen år og dukket kun glimtvis opp, før den igjen kom på dagsorden med etableringen av den første ‘rød-grønne’ regjeringen i 2005. Den ble et tema i denne regjeringens stortingsmelding om “St.meld. 17 (2006-7) Eit informasjonssamfunn for alle” fra 2006. Selv om retorikken var noe annerledes, ble tidligere regjeringers prioriteringer i IT-politikk i hovedsak videreført i denne. Det er med andre ord konsensus på tvers av partier og partiblokker og ikke kontrovers som har preget den offentlige IT-politikken de siste tjue åra.

Forskningsnettet mot år 2000